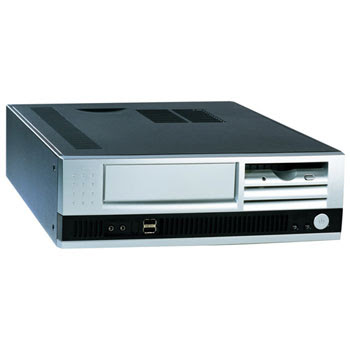

La caja del ordenador.

La caja de los ordenador se rige por una serie de características que debe tener para su correcta utilidad que son:

-Rigidez

-Ventilacion

-Peso

Las partes laterales, una de ellas esta cubierta mientras que la otra tiene orificios para una correcta ventilacion y que no se sobrecaliente.

La parte posterior de la caja se reserca para la fuente de alimentacion,la ranuras de expansión y el panel lateral de la placa.

La parte frontal ser reserva para las disqueteras y el botón de reinicio y encendido básicamente.

SEGÚN ESTAS CARACTERÍSTICAS,existen diferentes tipos de torres:

Microtorre

La fuente de alimentacion.

La fuente de alimentacion proporciona energía tanto al ordenador en si como a los componentes que se encuentran en su interior(disqueteras,memoria ram....)

La fuente de alimentacion proporciona energía tanto al ordenador en si como a los componentes que se encuentran en su interior(disqueteras,memoria ram....)

Existen también diferentes modelos de fuentes de alimentacion como la AT o la ATX cada una con sus respectivas características.

Cuando se trata de un portátil cambia un poco la cosa por que carecen de fuente de alimentacion sustituyendola por un adaptador de corriente.

La Placa base.

La placa base determina tanto el modelo de torre como la fuente de alimentacion y es donde se conectan todos los componentes del ordenador.

El Microprocesador.

El microprocesador es el circuito que gobierna todos los componentes del ordenador.Se aloja en el socket.

El microprocesador es el circuito que gobierna todos los componentes del ordenador.Se aloja en el socket.

Sus características mas importantes son:

-La velocidad del reloj

-El numero de núcleos

-El bus del sistema

-La memoria cache

A la hora de elegir un microprocesador hay que mirar bien las características que queremos que tenga y la utilidad que le vallamos a dar.

El sistema de refrigeracion.

El sistema de refrigeracion por aire esta compuesto por un conjunto de ventiladores y disipadores que mantienen una temperatura adecuada.

El sistema de refrigeracion por aire esta compuesto por un conjunto de ventiladores y disipadores que mantienen una temperatura adecuada.

Para ello se fijan 2 objetivos:

-Reducir la temperatura de los componentes específicos del equipo que generen mucho calor.

-Reducir la temperatura del interior de la caja

El sistema de refrigeracion básico consta de un elemento llamado disipador.El disipador esta fabricado en una aleación que absorbe el calor.Se coloca encima del componente que va a refrigerar.Si el disipador no es suficiente se usa un ventilador que se fija a la parte superior y extrae el aire caliente.

El sistema de refrigeracion básico consta de un elemento llamado disipador.El disipador esta fabricado en una aleación que absorbe el calor.Se coloca encima del componente que va a refrigerar.Si el disipador no es suficiente se usa un ventilador que se fija a la parte superior y extrae el aire caliente.

La memoria RAM.

La memoria RAM es el dispositivo donde se almacenan los datos e instrucciones necesatios para el correcto funcionamiento del equipo.

Hay dos tipos:

-Dinámica:Su lectura es destructiva,por lo que hay que refrescar.

La memoria SRAM tiene una capacidad reducida pero su velocidad es muy rápida.

en cambio la DRAM es mucho mas lenta que la SRAM pero admite mayores capacidades y es mas barata.Hay dos tipo de DRAM pero,por su uso,destacamos la SDRAM,cuyas variables son:

-SDR

-DDR

La memoria RAM para portátiles es mas limitada.Los módulos se llaman SoDIMMy son mucho mas pequeños.

Mantiene la distinción de modelos usando la situación de la muesca en la zona de contacto.

Los dispositivos de almacenamiento.

En los dispositivos de almacenamiento se guardan, de forma temporal o permanente,datos y programas que se manejan en el equipo.

para empezar hay diferentes unidades de almacenamiento:

-El disco duro:es el principal dispositivo de almacenamiento del equipo y su cometido es contener,entre otros datos,el sistema operativo.La capacidad de un disco duro puede ser muy variable.Se coloca en la parte frontal inferior de la caja.

-La disquetera:utiliza un soporte magnético llamado disquete para leer y escribir la información.Se coloca en la parte frontal debido a su tamaño reducido.

-La unidad óptica:dentro de este tipo de dispositivos se encuentran las unidades de lectura y gradación de CD, DVD o BlueRay.

-El lector de tarjetas:este dispositivo agrupa ranuras para diversos tipos de tarjetas flash. Dischas tarjetas suelen utilizarse en aparatos electrónicos como cámaras, teléfonos...Al tener el mismo tamaño que la disquetera, ocupa su lugar en la caja, aunque algunos modelos vienen con un adaptador para colocarlo en una ranura mas grande.

-Dispositivos de almacenamiento en portátiles:en los portátiles el disco duro es mucho mas pequeño, ya no existe la disquetera para portátiles, la unidad óptica suele ser combo y el lector de tarjetas esta integrado en la placa y no es tan completo.

Las tarjetas de expansión.

Se utilizan cuando un equipo carece de algunas de las funciones que proporcionan los diferentes tipos de tarjetas o cuando la placa base ofrece esas funciones pero queremos mejorarlas.

-La tarjeta gráfica:es la tarjeta mas utilizada a pesar de venir integrada en la placa base.Es tan importante que tiene su propia GPU y memoria RAM.Las especificaciones que suelen aparecer en las tartjetas grafícas son:el fabricante, información sobre su RAM y el tipo de interfaz.

-La tarjeta de sonido:Se utiliza especialmente para videojuegos y multimedia.Salvo necesidades muy concretas, suele emplearse la que viene integrada en la placa.La tarjeta de sonido se basa en un chip que procesa la señal de audio, no tiene ni CPU ni RAM.

Existen otras tarjetas de expansión dedicadas a multimedia o a aumentar los puertos.

-El disco duro:es el principal dispositivo de almacenamiento del equipo y su cometido es contener,entre otros datos,el sistema operativo.La capacidad de un disco duro puede ser muy variable.Se coloca en la parte frontal inferior de la caja.

-La disquetera:utiliza un soporte magnético llamado disquete para leer y escribir la información.Se coloca en la parte frontal debido a su tamaño reducido.

-La unidad óptica:dentro de este tipo de dispositivos se encuentran las unidades de lectura y gradación de CD, DVD o BlueRay.

-El lector de tarjetas:este dispositivo agrupa ranuras para diversos tipos de tarjetas flash. Dischas tarjetas suelen utilizarse en aparatos electrónicos como cámaras, teléfonos...Al tener el mismo tamaño que la disquetera, ocupa su lugar en la caja, aunque algunos modelos vienen con un adaptador para colocarlo en una ranura mas grande.

-Dispositivos de almacenamiento en portátiles:en los portátiles el disco duro es mucho mas pequeño, ya no existe la disquetera para portátiles, la unidad óptica suele ser combo y el lector de tarjetas esta integrado en la placa y no es tan completo.

Las tarjetas de expansión.

Se utilizan cuando un equipo carece de algunas de las funciones que proporcionan los diferentes tipos de tarjetas o cuando la placa base ofrece esas funciones pero queremos mejorarlas.

-La tarjeta gráfica:es la tarjeta mas utilizada a pesar de venir integrada en la placa base.Es tan importante que tiene su propia GPU y memoria RAM.Las especificaciones que suelen aparecer en las tartjetas grafícas son:el fabricante, información sobre su RAM y el tipo de interfaz.

-La tarjeta de sonido:Se utiliza especialmente para videojuegos y multimedia.Salvo necesidades muy concretas, suele emplearse la que viene integrada en la placa.La tarjeta de sonido se basa en un chip que procesa la señal de audio, no tiene ni CPU ni RAM.

Existen otras tarjetas de expansión dedicadas a multimedia o a aumentar los puertos.